人工智能正在重塑我们的数字世界。从高效的编码助手到强大的内容生成引擎,AI 的潜力显而易见。然而,随着开放互联网逐渐被个人“提示框”取代,一个根本性问题摆在我们面前:AI 会将我们引向一个更开放的互联网,还是一个由少数巨头控制、充满新付费墙的迷宫?

控制——这是核心问题。幸运的是,当一种强大的中心化力量出现时,另一种去中心化力量也随之成熟。这正是加密技术发挥作用的地方。

区块链不仅仅是数字货币;它是一种构建互联网服务的新架构范式——一个去中心化、无需信任、中立且可由用户集体拥有的网络。它为我们提供了一套强大的工具,以对抗 AI 模型日益中心化的趋势,重新协商当今系统背后的经济学,并最终实现一个更开放、更健壮的互联网。

这个想法并不新鲜,但它常常被模糊定义。为了使讨论更具体,我们探讨了 11 种已在实践中探索的应用场景。这些场景植根于当今正在构建的技术,展示了加密技术如何应对 AI 带来的最紧迫挑战。

第一部分:身份——重塑�我们在数位世界的「存在」

在机器人与人类越来越难以区分的数位世界中,「你是谁」以及「你能证明什么」变得至关重要。

1. AI 交互中的持久化上下文

问题:当前的 AI 工具存在“失忆症”问题。每次您开启新的 ChatGPT 会话时,都必须重新告知它您的工作背景、编程偏好和沟通风格。您的上下文被困在孤立的应用程序中,无法移植。

Web3 解决方案:将用户上下文(例如偏好、知识库)作为持久化的数字资产存储在区块链上。用户拥有并控制这些数据,并且可以授权任何 AI 应用程序在会话开始时加载它们。这不仅实现了无缝的跨平台体验,而且还允许用户直接将其专业知识变现。

2. AI 代理的通用身份

问题:当 AI 代理开始代表我们执行任务(预订、交易、客户服务)时,我们如何识别它们、支付它们,并验证它们的能力和声誉?如果每个代理的身份都绑定到单一平台,其价值将大大降低。

加密解决方案:为每个 AI 代理创建一个�基于区块链的“通用护照”。该护照集成了钱包、API 注册表、版本历史和声誉系统。任何界面(电子邮件、Slack、其他代理)都可以用相同的方式解析并与之交互,从而构建一个无需许可、可组合的代理生态系统。

3. 面向未来的“人格证明”

问题:深度伪造、社交媒体上的机器人大军、约会应用上的虚假账户……人工智能的泛滥正在侵蚀我们对在线真实性的信任。

加密解决方案:去中心化的“人格证明”机制(例如 World ID)允许用户在保护隐私的同时,证明他们是独一无二的人类。这种证明由用户自主保管,可跨平台重复使用,并具有未来兼容性。它能清晰地将人类网络与机器网络区分开来,为更真实、更安全的数字体验奠定基础。

第二部分:去中心化基础设施——为开放式 AI 铺设轨道

AI 的智能取决于其背后的物理和数字基础设施。去中心化是确保这些基础设施不被少数人垄断的关键。

4. 去中心化物理基础设施网络 (DePIN) 赋能 AI

问题:AI 发展受限于算力与能源瓶颈,这些资源被少数超大规模云服务提供商牢牢掌控。

加密解决方案:DePIN 通过激励机制在全球范围内聚合未充分利用的物理资源——从业余玩家的电脑到数据中心闲置的芯片。这创造了一个无需许可的分布式计算市场,大幅降低了 AI 创新的门槛,并提供抗审查性。

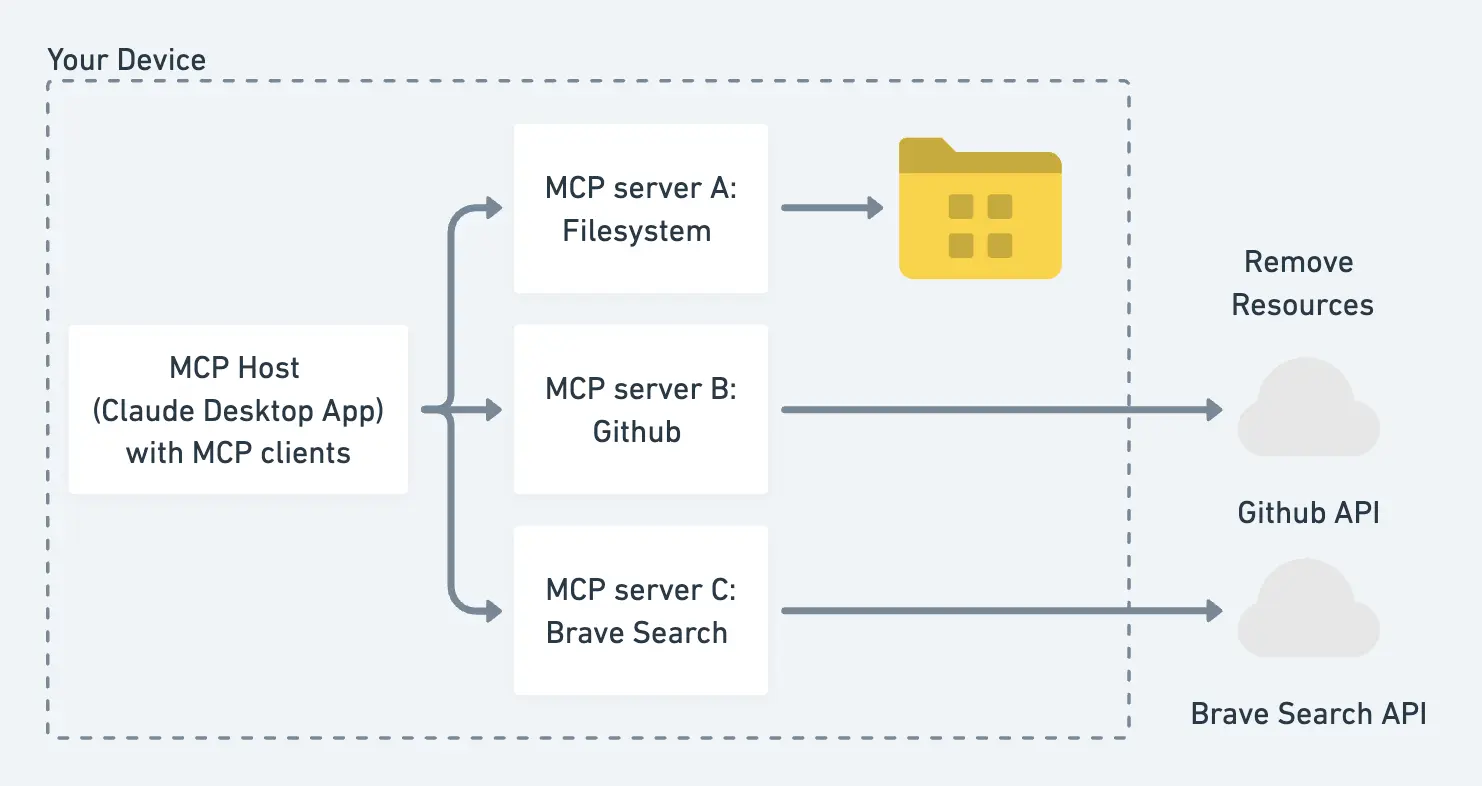

5. AI 代理交互的基础设施与保障机制

问题:复杂任务通常需要多个专业 AI 代理之间进行协作。然而,它们大多在封闭的生态系统中运行,缺乏开放的交互标准和市场。

加密解决方案:区块链可以为代理交互提供一个开放、标准化的“轨道”。从发现、协商到支付,整个过程可以通过智能合约在链上自动执行,确保 AI 行为与用户意图保持一致,无需人工干预。

6. 保持 AI 编码应用程序的同步

问题:AI 使任何人都能快速构建定制化软件(“Vibe 编程”)。但这带来了新的混乱:当成千上万个不断变化的定制应用��程序需要相互通信时,我们如何确保它们保持兼容性?

加密解决方案:在区块链上创建一个“同步层”。这是一个共享的、动态更新的协议,所有应用程序都可以连接到该协议,以保持相互兼容。通过加密经济激励,鼓励开发者和用户共同维护和改进这个同步层,从而形成一个自我成长的生态系统。

第三部分:新经济与激励模型——重塑价值创造与分配

人工智能正在颠覆现有的互联网经济。加密技术提供了一套工具,以重新调整激励机制,确保价值链中所有贡献者获得公平报酬。

7. 收益分享式小额支付

问题:AI 模型通过学习海量的互联网内容来创造价值,但原始内容创作者却一无所获。随着时间的推移,这将扼杀开放互联网的创造活力。

加密解决方案:建立一个自动归因和收益分享系统。当 AI 行为发生时(例如生成报告或促成交易),智能合约可以自动向其引用的所有信息源支付一笔微小的费用(微支付或纳支付)。这在经济上是可行的,因为它利用了低成本的区块链技术,如 Layer 2。

8. 知识产权 (IP) 和溯源注册表

问题:在人工智能可以即时生成和混编内容的时代,传统的知识产权框架显得力不从心。

加密解决方案:利用区块链作为公共的、不可篡改的知识产权注册表。创作者可以通过可编程智能合约清晰地确立所有权,并设定许可、混编和收益分享的规则。这将人工智能从对创作者的威胁转变为价值创造和分配的新机遇。

9. 让网络爬虫为数据付费

问题:AI 公司的网络爬虫免费抓取网站数据,消耗网站所有者的带宽和计算资源,却不支付任何报酬。作为回应,网站所有者开始大规模屏蔽这些爬虫。

加密解决方案:建立一个双轨制系统:AI 爬虫在抓取数据时,通过链上协商向网站支付费用。同时,人类用户可以通过“人格证明”(proof of personhood)验证身份,并继续免费访问内容。这既能补偿数据贡献者,又能保护人类用户的体验。

10. 量身定制且“不令人毛骨悚然”的隐私保护广告

问题:当今的广告要么无关紧要,要么因过度追踪用户数据而令人不安。

加密解决方案:用户可以授权其 AI 代理使用零知识证明等隐私技术向广告商证明某些属性,而无需透露个人身份。这使得广告高度相关且有用。作为回报,用户可以通过分享数据或与广告互动来获得小额支付,从而将当前的“掠夺式”广告模式转变为“参与式”模式。

第四部分:掌控人工智能的未来——确保控制权仍在用户手中

随着我们与人工智能的关系变得越来越个人化和深刻,所有权和控制权的问题变得至关重要。

11. 人类拥有和控制的AI伴侣

问题:在不久的将来,我们将拥有无限耐心、高度个性化的AI伴侣(用于教育、医疗保健、情感支持)。但谁将控制这些关系?如果公司掌握控制权,他们可以审查、操纵,甚至删除你的AI伴侣。

加密解决方案:将AI伴侣托管在抗审查的去中心化网络上。用户可以通过自己的钱包真正拥有和控制他们的AI(得益于账户抽象和关键技术,使用门槛已大大降低)。�这意味着你与AI的关系将是永久且不可剥夺的。

结论:共同打造我们想要的未来

AI 与加密技术的融合,不仅仅是两种热门技术的结合。它代表着对未来网路形式的一个根本性选择:我们是走向由少数公司控制的封闭系统,还是走向由所有参与者共同建立和拥有的开放生态系统?

这 11 个应用场景并非遥不可及的幻想;它们是全球开发者社群正在积极探索的方向——其中包括 Cuckoo Network 的许多建设者。前方的道路充满挑战,但工具已掌握在我们手中。现在,是时候开始建设了。