Cuckoo Network × BeFreed.ai:去中心化AI赋能个性化学习

Cuckoo Network 欣然宣布与 BeFreed.ai 建立战略合作伙伴关系,BeFreed.ai 是一个开创性的AI驱动个性化学习平台。此次合作标志着我们向未来迈出了重要一步,即去中心化、社区驱动的AI将为愉悦、碎片化的教育新时代提供坚实支撑。

此次合作为何重要

在一个信息爆炸的世界里,高效且愉悦地学习是一种超能力。BeFreed.ai 抓住了现代学习的精髓,将书籍、播客和视频转化为引人入胜的闪卡、智能聊天互动和易于消化的音频片段。他们的使命是赋能任何人“在几分钟内愉悦地学习任何知识”。

在 Cuckoo Network,我们正在为更开放、更公平的AI格局构建基础设施。我们基于 Arbitrum 和以太坊构建的无需许可的GPU网络,实现了经济高效且社区拥有的AI模型服务。我们相信AI的力量应该掌握在多数人手中,而非少数人。

此次合作将创新的AI原生学习体验与强大、去中心化的计算骨干相结合。其结果是一种强大的协同效应,您喜爱的内容将由全球学习者和贡献者社区提供支持,从而创建一个知识的自我维持生态系统。

各方贡献

此次合作建立在双方平台的独特优势之上:

BeFreed.ai:

- 自适应学习工具: 提供个性化摘要、互动播客和智能闪卡,使学习高效且引人入胜。

- 蓬勃发展的社区: 拥有超过43,000名活跃学习者的充满活力的社区,他们热衷于获取新鲜、高质量的知识。

Cuckoo Network:

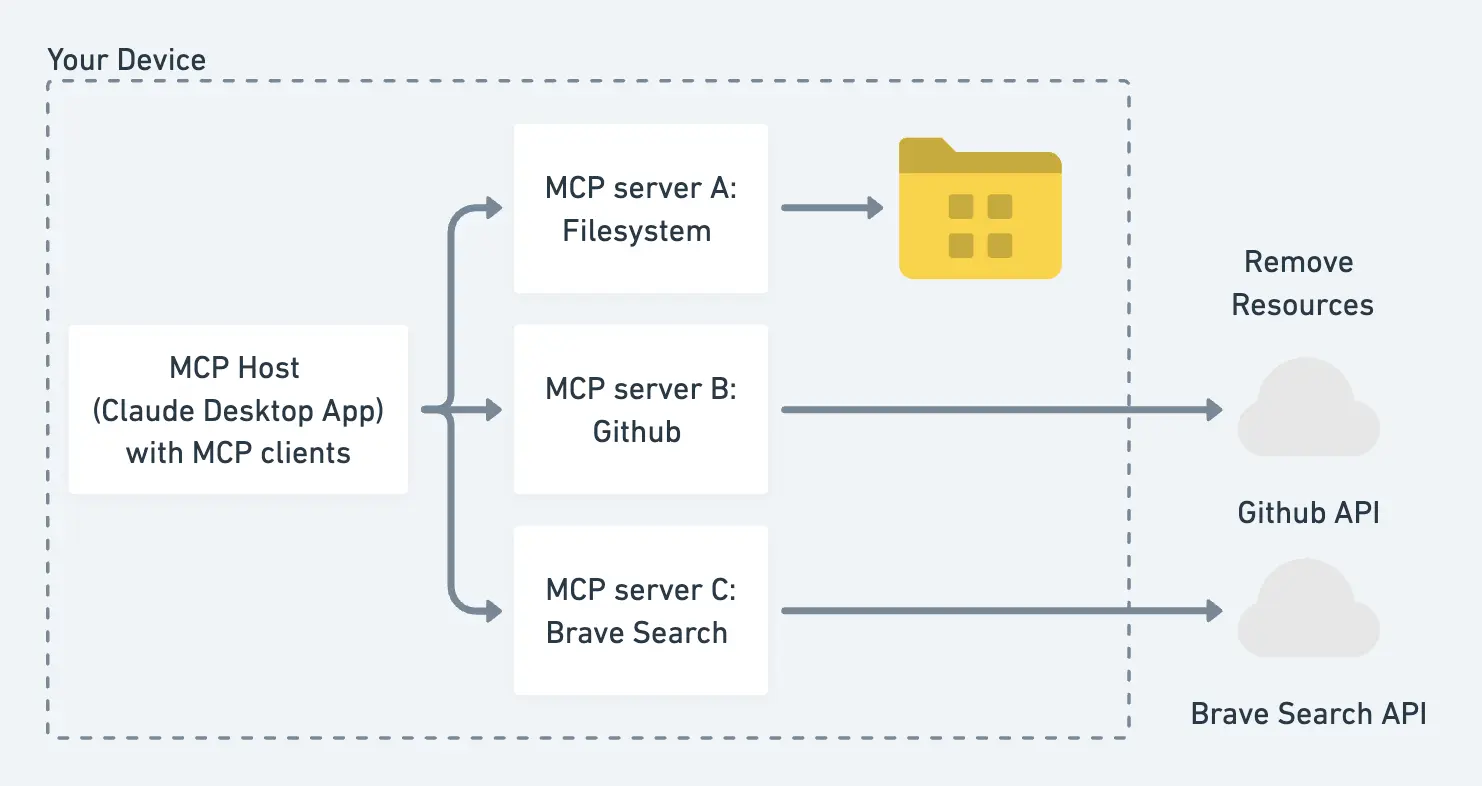

- 去中心化GPU市场: 为GPU提供商提供分布式网络,并为矿工和开发者提供链上激励。

- 无缝AI部署: 通过我们的原生代币 $CAI 提供无摩擦的模型托管、透明的计费和安全的质押。

首批倡议:共同构建学习的未来

我们的合作将通过一系列激动人心的倡议启动,旨在整合我们的平台并立即为我们的社区带来价值:

- 链上微学习任务: 在 BeFreed.ai 上完成“快速课程”的学习者将获得学习证明NFT和 $CAI 代币奖励。这在学习和收益之间建立了切实联系,激励教育参与。

- 社区驱动的模型服务: 为 BeFreed.ai 的摘要和语音合成功�能提供支持的AI模型将托管在 Cuckoo Network 的分布式节点上。这使得GPU提供商在赚取奖励的同时,直接支持他人的学习旅程。

- 透明度与治理: 关于平台未来的关键决策,例如引入新的语言包,将在 Cuckoo Chain 上进行投票。这使得 $CAI 持有者和 BeFreed.ai 学习者都能直接参与生态系统的演变。

展望未来:不断扩展的知识宇宙

此次合作仅仅是个开始。我们对一个学习无限、社区驱动的未来抱有共同愿景。我们的长期目标包括:

- 扩展内容目录: 我们计划引入针对复杂主题(如 Solidity 安全和产品主导增长)的领域特定深度学习内容,以易于理解的格式提供专家级知识。

- 自带模型(Bring-Your-Own-Model): 我们将通过在 Cuckoo Network 上提供“自带模型”插槽,赋能教育者和创作者发布他们自己的定制课程,从而消除复杂的 DevOps 工作需求。

- 探索共享声誉系统: 我们正在探索共享声誉系统的创新模型。通过更快完成任务来展示专业知识的学习者可以质押其声誉,成为轻量级审核节点,从而帮助加速内容审核并维护质量。

加入我们,共赴征程

无论您是渴望更快学习的好奇心,寻求新机遇的GPU矿工,还是希望与世界分享知识的创作者,我们都诚挚邀请您加入我们不断壮大的社区。

- 关注 @CuckooNetworkHQ 获取最新开发动态。

- 立即在 iOS 或 Android 上下载 BeFreed.ai 应用,通过“快速摘要”体验学习的未来。

我们携手共进,正在构建一个公平、愉悦、真正社区驱动的知识网络——每一步,每一课。