打破 AI 上下文障碍:理解模型上下文协议

我们经常谈论更大的模型、更大的上下文窗口和更多的参数。但真正的突破可能根本不在于规模。模型上下文协议 (MCP) 代表了一种范式转变,改变了 AI 助手与周围世界互动的方式,而这一切正在发生。

AI 助手的真正问题

这是每个开发者都知道的场景:你在使用 AI 助手调试代码,但它无法查看你的代码库。或者你询问市场数据,但它的知识已经过时几个月。根本的限制不是 AI 的智能,而是它无法访问真实世界。

大型语言模型 (LLM) 就像被锁在房间里的聪明学者,只有他们的训练数据陪伴。无论他们变得多聪明,他们都无法查看当前的股票价格、查看你的代码库或与工具互动。直到现在。

引入模型上下文协议 (MCP)

MCP 从根本上重新构想了 AI 助手与外部系统的互动方式。与其试图在越来越大的参数模型中塞入更多上下文,MCP 创造了一种标准化的方法,让 AI 可以根据需要动态访问信息和系统。

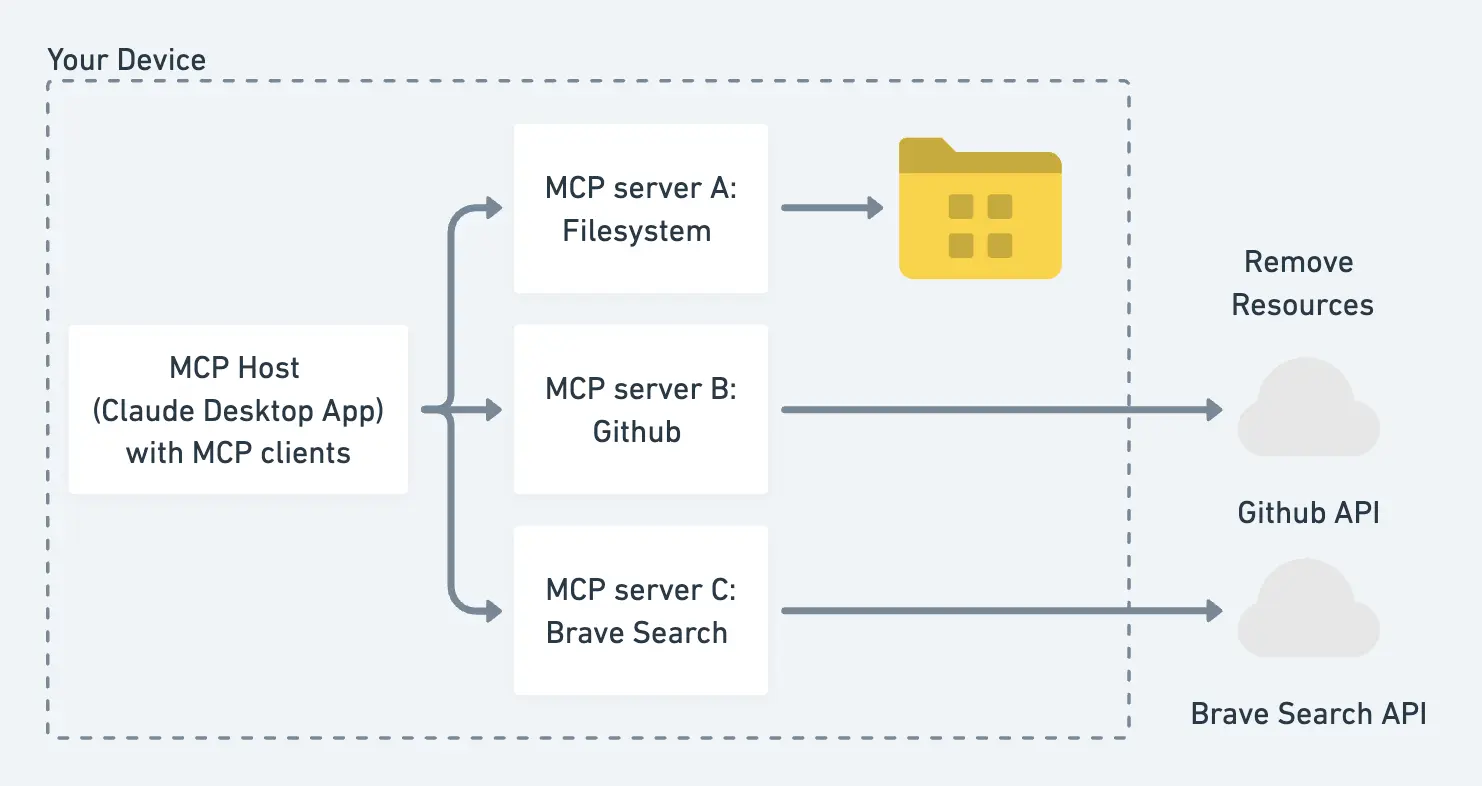

架构优雅而强大:

-

MCP 主机:像 Claude Desktop 这样的程序或工具,AI 模型在其中操作并与各种服务互动。主机为 AI 助手提供运行时环境和安全边界。

-

MCP 客户端:AI 助手中的组件,发起请求并处理与 MCP 服务器的通信。每个客户端维护一个专用连接,以执行特定任务或访问特定资源,管理请求-响应周期。

-

MCP 服务器:轻量级、专门化的程序,公开特定服务的能力。每个服务器都专门用于处理一种类型的集成,无论是通过 Brave 搜索网络、访问 GitHub 仓库还是查询本地数据库。这里有开源服务器。

-

本地和远程资源:MCP 服务器可以访问的底层数据源和服务。本地资源包括计算机上的文件、数据库和服务,而远程资源则包括服务器可以安全连接的外部 API 和云服务。

可以将其视为为 AI 助手提供了一个 API 驱动的感官系统。与其在训练期间尝试记住所有内容,它们现在可以查询所需的信息。

为什么这很重要:三个突破

- 实时智能:AI 助手不再依赖过时的训练数据,而是可以从权威来源获取当前信息。当你询问比特币的价格时,你得到的是今天的数字,而不是去年的。

- 系统集成:MCP 使得与开发环境、业务工具和 API 的直接互动成为可能。你的 AI 助手不仅仅是在谈论代码——它实际上可以查看和与代码库互动。

- 设计安全性:客户端-主机-服务器模型创建了明确的安全边界。组织可以实施细粒度的访问控制,同时保持 AI 辅助的好处。不再需要在安全性和能力之间做出选择。

眼见为实:MCP 的实际应用

让我们使用 Claude Desktop App 和 Brave Search MCP 工具设置一个实际示例。这将使 Claude 能够实时搜索网络:

1. 安装 Claude Desktop

2. 获取一个 Brave API 密钥

3. 创建一个配置文件

open ~/Library/Application\ Support/Claude

touch ~/Library/Application\ Support/Claude/claude_desktop_config.json

然后将文件修改为如下内容:

{

"mcpServers": {

"brave-search": {

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-brave-search"

],

"env": {

"BRAVE_API_KEY": "YOUR_API_KEY_HERE"

}

}

}

}

4. 重新启动 Claude Desktop App

在应用程序的右侧,你会注意到两个新的工具(在下图中的红色圆圈中突出显示),用于使用 Brave Search MCP 工具进行互联网搜索。

一旦配置完成,转换是无缝的。询问 Claude 关于曼联最近的比赛,而不是依赖过时的训练数据,它会执行实时网络搜索以提供准确、最新的信息。

更大的图景:为什么 MCP 改变一切

这里的影响远远超出了简单的网络搜索。MCP 为 AI 辅助创造了一个新的范式:

- 工具集成:AI 助手现在可以使用任何具有 API 的工具。想想 Git 操作、数据库查询或 Slack 消息。

- 现实基础:通过访问当前数据,AI 的响应变得基于现实而非训练数据。

- 可扩展性:协议设计用于扩展。随着新工具和 API 的出现,它们可以快速集成到 MCP 生态系统中。

MCP 的未来

我们只是看到了 MCP 可能性的开始。想象一下 AI 助手可以:

- 获取和分析实时市场数据

- 直接与开发环境互动

- 访问和总结公司内部文档

- 在多个业务工具之间协调以自动化工作流程

前进的道路

MCP 代表了我们对 AI 能力思考方式的根本转变。与其构建具有更大上下文窗口的更大模型,我们正在创造更智能的方法,让 AI 与现有系统和数据互动。

对于开发者、分析师和技术领导者来说,MCP 为 AI 集成开辟了新的可能性。这不仅仅是关于 AI 知道什么,而是关于它能做什么。

AI 的真正革命可能不是让模型变得更大,而是让它们更具连接性。随着 MCP,这场革命已经到来。