هوش مصنوعی در حال تغییر شکل دنیای دیجیتال ما است. از دستیاران کدنویسی کارآمد گرفته تا موتورهای قدرتمند تولید محتوا، پتانسیل هوش مصنوعی آشکار است. با این حال، همانطور که اینترنت باز به تدریج با «جعبههای اعلان» فردی جایگزین میشود، یک سوال اساسی پیش روی ما قرار میگیرد: آیا هوش مصنوعی ما را به سمت اینترنتی بازتر هدایت خواهد کرد، یا به سمت هزارتویی که توسط چند غول کنترل میشود و پر از دیوارهای پرداخت جدید است؟

کنترل—این مسئله اصلی است. خوشبختانه، زمانی که یک نیروی قدرتمند متمرکزکننده ظهور میکند، نیروی غیرمتمرکزکننده دیگری نیز به بلوغ میرسد. اینجاست که کریپتو وارد میشود.

بلاکچین فقط در مورد ارز دیجیتال نیست؛ بلکه یک پارادایم معماری جدید برای سا�خت خدمات اینترنتی است—یک شبکه خنثی، غیرمتمرکز و بدون نیاز به اعتماد که میتواند به صورت جمعی توسط کاربران مالکیت شود. این ابزارها مجموعهای قدرتمند را برای مقابله با روند فزاینده تمرکزگرایی مدلهای هوش مصنوعی، مذاکره مجدد در مورد اقتصاد زیربنایی سیستمهای امروزی، و در نهایت دستیابی به اینترنتی بازتر و قویتر در اختیار ما قرار میدهد.

این ایده جدید نیست، اما اغلب به طور مبهم تعریف میشود. برای ملموستر کردن بحث، ما ۱۱ سناریوی کاربردی را بررسی میکنیم که در حال حاضر در عمل در حال کاوش هستند. این سناریوها ریشه در فناوریهایی دارند که امروزه در حال ساخت هستند و نشان میدهند که چگونه کریپتو میتواند به چالشبرانگیزترین مسائل ناشی از هوش مصنوعی بپردازد.

بخش اول: هویت—بازتعریف "وجود" ما در دنیای دیجیتال

در دنیای دیجیتال که در آن رباتها و انسانها به طور فزایندهای غیرقابل تشخیص میشوند، "شما کیستید" و "چه چیزی را میتوانید اثبات کنید" حیاتی میشوند.

۱. بستر پایدار در تعاملات هوش مصنوعی

مشکل: ابزارهای هوش مصنوعی کنونی از "فراموشی" رنج میبرند. هر بار که یک جلسه جدید چتجیپیتی را باز میکنید، باید دوباره سابقه کاری، ترجیحات برنامهنویسی و سبک ارتباطی خود را به آن بگویید. بستر شما در برنامههای جداگانه به دام افتاده است و قابل انتقال نیست.

راهحل کریپتو: بستر کاربر (مانند ترجیحات، پایگاههای دانش) را به عنوان داراییهای دیجیتال پایدار در بلاکچین ذخیره کنید. کاربران مالک و کنترلکننده این دادهها هستند و میتوانند به هر برنامه هوش مصنوعی اجازه دهند تا آن را در ابتدای یک جلسه بارگذاری کند. این نه تنها تجربیات یکپارچه بین پلتفرمی را امکانپذیر میسازد، بلکه به کاربران اجازه میدهد تا مستقیماً از تخصص خود کسب درآمد کنند.

2. هویت جهانی برای عوامل هوش مصنوعی

مشکل: هنگامی که عوامل هوش مصنوعی شروع به انجام وظایف از طرف ما میکنند (رزرو، تجارت، خدمات مشتری)، چگونه آنها را شناسایی کنیم، به آنها پرداخت کنیم و قابلیتها و شهرتشان را تأیید کنیم؟ اگر هویت هر عامل به یک پلتفرم واحد گره خورده باشد، ارزش آن به شدت کاهش خواهد یافت.

راهحل کریپتو: یک "گذرنامه جهانی" مبتنی بر بلاکچین برای هر عامل هوش مصنوعی ایجاد کنید. این گذرنامه، کیف پول، ثبت API، تاریخچه نسخه و سیستم شهرت را یکپارچه میکند. هر رابطی (ایمیل، اسلک، عامل دیگر) میتواند آن را به یک روش یکسان تجزیه و با آن تعامل کند و یک اکوسیستم عامل بدون نیاز به مجوز و قابل ترکیب را بسازد.

3. اثبات هویت انسانی "مقاوم در برابر آینده"

مشکل: دیپفیکها، ارتش رباتها در شبکههای اجتماعی، حسابهای جعلی در برنامههای دوستیابی... گسترش هوش مصنوعی در حال از بین بردن اعتماد ما به اصالت آنلاین است.

راهحل کریپتو: سازوکارهای غیرمتمرکز "اثبات هویت انسانی" (مانند World ID) به کاربران اجازه میدهند ثابت کنند که انسانهای منحصربهفردی هستند، در عین محافظت از حریم خصوصی. این اثبات توسط کاربران خود-حضانتی میشود، در پلتفرمهای مختلف قابل استفاده مجدد است و با آینده سازگار است. این میتواند شبکههای انسانی را به وضوح از شبکههای ماشینی جدا کند و پایهای برای تجربههای دیجیتالی اصیلتر و امنتر فراهم آورد.

بخش دوم: زیرساخت غیرمتمرکز — هموارسازی مسیر برای هوش مصنوعی باز

هوشمندی هوش مصنوعی به زیرساختهای فیزیکی و دیجیتال پشت آن بستگی دارد. غیرمتمرکزسازی کلید تضمین این است که این زیرساختها توسط تعداد کمی انحصار نشوند.

4. شبکههای زیرساخت فیزیکی غیرمتمرکز (دیپین) برای هوش مصنوعی

مشکل: پیشرفت هوش مصنوعی با تنگناهای قدرت محاسباتی و انرژی محدود شده است، در حالی که این منابع به شدت توسط چند ارائهدهنده ابری فوقمقیاس کنترل میشوند.

راهحل کریپتو: دیپین منابع فیزیکی کمکاربرد را در سطح جهانی از طریق مکانیزمهای انگیزشی —از رایانههای شخصی گیمرهای آماتور گرفته تا تراشههای بیکار در مراکز داده— جمعآوری میکند. این یک بازار محاسباتی غیرمتمرکز و بدون نیاز به مجوز ایجاد میکند که به شدت مانع نوآوری هوش مصنوعی را کاهش میدهد و مقاومت در برابر سانسور را فراهم میکند.

۵. زیرساخت و چارچوبهای محافظ برای تعاملات عاملهای هوش مصنوعی

مشکل: وظایف پیچیده اغلب نیازمند همکاری بین چندین عامل هوش مصنوعی تخصصی هستند. با این حال، آنها عمدتاً در اکوسیستمهای بسته فعالیت میکنند و فاقد استانداردهای تعامل باز و بازار هستند.

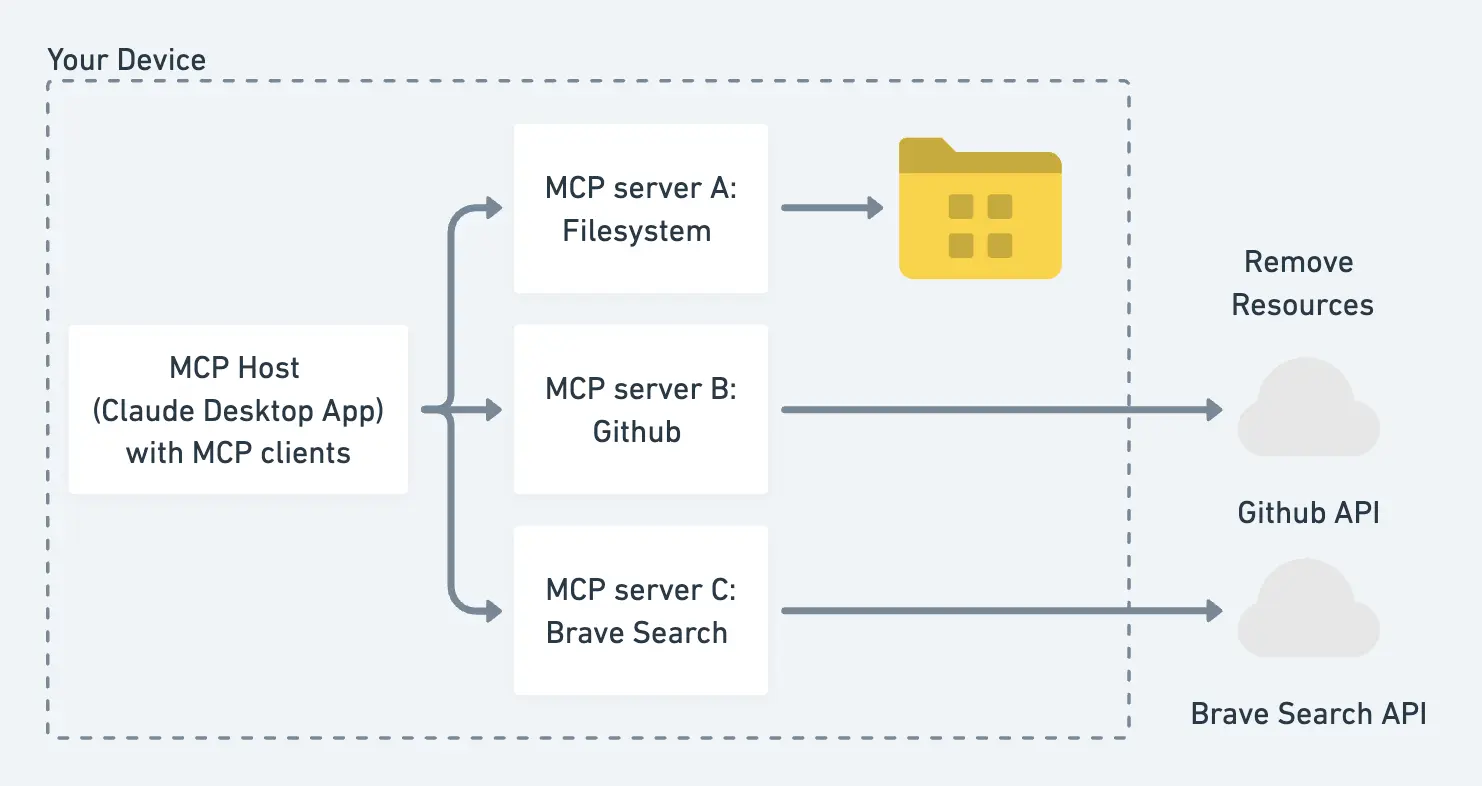

راهحل کریپتو: بلاکچین میتواند یک "مسیر" باز و استانداردشده برای تعاملات عاملها فراهم کند. از کشف و مذاکره تا پرداخت، کل فرآیند میتواند به صورت خودکار روی زنجیره از طریق قراردادهای هوشمند اجرا شود و تضمین کند که رفتار هوش مصنوعی بدون دخالت انسان با نیت کاربر همسو باشد.

6. همگامسازی برنامههای کدنویسی شده توسط هوش مصنوعی

مشکل: هوش مصنوعی به هر کسی امکان میدهد تا به سرعت نرمافزارهای سفارشی ("کدنویسی حسی") بسازد. اما این امر هرج و مرج جدیدی را به همراه دارد: وقتی هزاران برنامه سفارشی که دائماً در حال تغییر هستند، نیاز به برقراری ارتباط با یکدیگر دارند، چگونه میتوانیم از سازگاری آنها اطمینان حاصل کنیم؟

راهحل کریپتو: یک "لایه همگامسازی" بر روی بلاکچین ایجاد کنید. این یک پروتکل مشترک و پویا است که همه برنامهها میتوانند برای حفظ سازگاری با یکدیگر به آن متصل شوند. از طریق انگیزههای اقتصادی-رمزنگاری، توسعهدهندگان و کاربران تشویق میشوند تا به طور جمعی این لایه همگامسازی را نگهداری و بهبود بخشند و یک اکوسیستم خودرشد ایجاد کنند.

بخش سوم: اقتصادهای نوین و مدلهای انگیزشی—بازتعریف خلق و توزیع ارزش

هوش مصنوعی در حال دگرگون کردن اقتصاد اینترنتی موجود است. کریپتو ابزارهایی را برای همسو کردن مجدد سازوکارهای انگیزشی فراهم میکند و پاداش عادلانهای را برای همه مشارکتکنندگان در زنجیره ارزش تضمین مینماید.

۷. پرداختهای خرد با اشتراک درآمد

مشکل: مدلهای هوش مصنوعی با یادگیری از حجم عظیمی از محتوای اینترنتی ارزش ایجاد میکنند، اما تولیدکنندگان اصلی محتوا هیچ سهمی دریافت نمیکنند. با گذشت زمان، این امر سرزندگی خلاقانه اینترنت باز را خفه خواهد کرد.

راهکار کریپتو: یک سیستم خودکار انتساب و اشتراک درآمد ایجاد کنید. هنگامی که رفتار هوش مصنوعی رخ میدهد (مانند تولید یک گزارش یا تسهیل یک تراکنش)، قراردادهای هوشمند میتوانند به طور خودکار یک هزینه ناچیز (پرداخت خرد یا نانوپرداخت) را به تمام منابع اطلاعاتی که به آنها ارجاع داده شده است، پرداخت کنند. این راهکار از نظر اقتصادی مقرون به صرفه است زیرا از فناوریهای بلاکچین کمهزینه مانند لایه ۲ استفاده میکند.

8. دفتر ثبت مالکیت فکری (IP) و اصالت

مشکل: در عصری که هوش مصنوعی میتواند محتوا را فوراً تولید و بازترکیب کند، چارچوبهای سنتی مالکیت فکری ناکافی به نظر میرسند.

راهحل بلاکچین: از بلاکچین به عنوان یک دفتر ثبت عمومی و تغییرناپذیر مالکیت فکری استفاده کنید. خالقان میتوانند به وضوح مالکیت را تثبیت کرده و قوانین مربوط به مجوزدهی، بازترکیب و تقسیم درآمد را از طریق قراردادهای هوشمند قابل برنامهریزی تعیین کنند. این امر هوش مصنوعی را از یک تهدید برای خالقان به یک فرصت جدید برای ایجاد و توزیع ارزش تبدیل میکند.

9. وادار کردن خزندههای وب به پرداخت هزینه برای داده

مشکل: خزندههای وب شرکتهای هوش مصنوعی آزادانه دادههای وبسایتها را جمعآوری میکنند و پهنای باند و منابع محاسباتی صاحبان وبسایت را بدون هیچ گونه جبرانی مصرف میکنند. در پاسخ، صاحبان وبسایتها شروع به مسدود کردن گسترده این خزندهها کردهاند.

راهحل رمزارزی: یک سیستم دو مسیره ایجاد کنید: خزندههای هوش مصنوعی هنگام جمعآوری داده، از طریق مذاکرات درونزنجیرهای (on-chain) هزینههایی را به وبسایتها پرداخت میکنند. در همین حال، کاربران انسانی میتوانند هویت خود را از طریق «اثبات هویت فردی» (proof of personhood) تأیید کرده و به صورت رایگان به محتوا دسترسی داشته باشند. این راهحل هم به مشارکتکنندگان داده پاداش میدهد و هم تجربه کاربری انسانی را حفظ میکند.

۱۰. تبلیغات شخصیسازی شده و غیر "آزاردهنده" با حفظ حریم خصوصی

مشکل: تبلیغات امروزی به دلیل ردیابی بیش از حد دادههای کاربر، یا بیربط هستند یا آزاردهنده.

راهحل کریپتو: کاربران میتوانند به عوامل هوش مصنوعی خود اجازه دهند تا از فناوریهای حفظ حریم خصوصی مانند اثباتهای دانش صفر استفاده کنند تا ویژگیهای خاصی را به تبلیغکنندگان اثبات کنند، بدون اینکه هویت شخصیشان فاش شود. این امر تبلیغات را بسیار مرتبط و مفید میکند. در ازای آن، کاربران میتوانند برای به اشتراک گذاشتن دادهها یا تعامل با تبلیغات، ریزپرداخت دریافت کنند و مدل تبلیغاتی "استخراجی" فعلی را به یک مدل "مشارکتی" تبدیل کنند.

بخش چهارم: مالکیت آینده هوش مصنوعی—اطمینان از باقی ماندن کنترل در دست کاربران

همانطور که رابطه ما با هوش مصنوعی به طور فزایندهای شخصی و عمیق میشود، مسائل مالکیت و کنترل حیاتی میشوند.

11. همراهان هوش مصنوعی تحت مالکیت و کنترل انسان

مسئله: در آینده نزدیک، ما همراهان هوش مصنوعی بسیار صبور و کاملاً شخصیسازی شده (برای آموزش، مراقبتهای بهداشتی، حمایت عاطفی) خواهیم داشت. اما چه کسی این روابط را کنترل خواهد کرد؟ اگر شرکتها کنترل را در دست داشته باشند، میتوانند همراه هوش مصنوعی شما را سانسور، دستکاری یا حتی حذف کنند.

راهحل رمزارزی: همراهان هوش مصنوعی را در شبکههای غیرمتمرکز و مقاوم در برابر سانسور میزبانی کنید. کاربران میتوانند از طریق کیف پولهای خود (به لطف انتزاع حساب و فناوریهای کلیدی، مانع استفاده به شدت کاهش یافته است) واقعاً هوش مصنوعی خود را مالک شوند و کنترل کنند. این بدان معناست که رابطه شما با هوش مصنوعی دائمی و غیرقابل سلب خواهد بود.

نتیجهگیری: ساختن آیندهای که میخواهیم

همگرایی هوش مصنوعی و رمزارز صرفاً ترکیب دو فناوری داغ نیست. این نشاندهنده یک انتخاب اساسی در مورد شکل آینده اینترنت است: آیا به سمت یک سیستم بسته که توسط چند شرکت کنترل میشود، حرکت میکنیم، یا به سمت یک اکوسیستم باز که به صورت جمعی توسط همه شرکتکنندگانش ساخته و مالکیت میشود؟

این ۱۱ سناریوی کاربردی، تخیلات دور از دسترس نیستند؛ آنها مسیرهایی هستند که به طور فعال توسط جامعه جهانی توسعهدهندگان—از جمله بسیاری از سازندگان در شبکه Cuckoo—در حال بررسی هستند. مسیر پیش رو پر از چالش است، اما ابزارها از قبل در دستان ما هستند. اکنون، زمان شروع ساختن است.