LinguaLinked: Tăng Cường Thiết Bị Di Động Với Các Mô Hình Ngôn Ngữ Lớn Phân Tán

Nhu cầu triển khai các mô hình ngôn ngữ lớn (LLM) trên thiết bị di động đang gia tăng, do nhu cầu về quyền riêng tư, giảm độ trễ và sử dụng băng thông hiệu quả. Tuy nhiên, yêu cầu về bộ nhớ và tính toán rộng rãi của LLM đặt ra những thách thức đáng kể. LinguaLinked, một hệ thống mới được phát triển bởi một nhóm các nhà nghiên cứu từ UC Irvine, ra đời để giải quyết vấn đề này, cho phép suy diễn LLM phân tán trên nhiều thiết bị di động, tận dụng khả năng tập thể của chúng để thực hiện các tác vụ phức tạp một cách hiệu quả.

Thách Thức

Việc triển khai các LLM như GPT-3 hoặc BLOOM trên thiết bị di động gặp phải các khó khăn sau:

- Giới Hạn Bộ Nhớ: LLM đòi hỏi bộ nhớ lớn, thường vượt quá khả năng của các thiết bị di động cá nhân.

- Hạn Chế Tính Toán: Thiết bị di động thường có công suất xử lý hạn chế, khiến việc chạy các mô hình lớn trở nên khó khăn.

- Lo Ngại Về Quyền Riêng Tư: Gửi dữ liệu đến các máy chủ tập trung để xử lý làm dấy lên các vấn đề về quyền riêng tư.

Giải Pháp Của LinguaLinked

LinguaLinked giải quyết các thách thức này bằng ba chiến lược chính:

- Phân Bố Mô Hình Tối Ưu:

- Hệ thống phân chia các LLM thành các đồ thị con nhỏ hơn bằng cách sử dụng tối ưu hóa tuyến tính để phù hợp với khả năng của từng thiết bị.

- Điều này đảm bảo việc sử dụng tài nguyên hiệu quả và giảm thiểu việc truyền dữ liệu giữa các thiết bị.

- Cân Bằng Tải Tại Thời Gian Thực:

- LinguaLinked liên tục giám sát hiệu suất của thiết bị và phân bổ lại các tác vụ để ngăn chặn tình trạng tắc nghẽn.

- Cách tiếp cận động này đảm bảo việc sử dụng hiệu quả tất cả các tài nguyên có sẵn, nâng cao khả năng phản hồi của hệ thống.

- Giao Tiếp Tối Ưu:

- Các bản đồ truyền dữ liệu hiệu quả hướng dẫn luồng thông tin giữa các thiết bị, duy trì tính toàn vẹn của cấu trúc mô hình.

- Phương pháp này giảm thiểu độ trễ và đảm bảo quá trình xử lý dữ liệu kịp thời trong toàn mạng lưới các thiết bị di động.

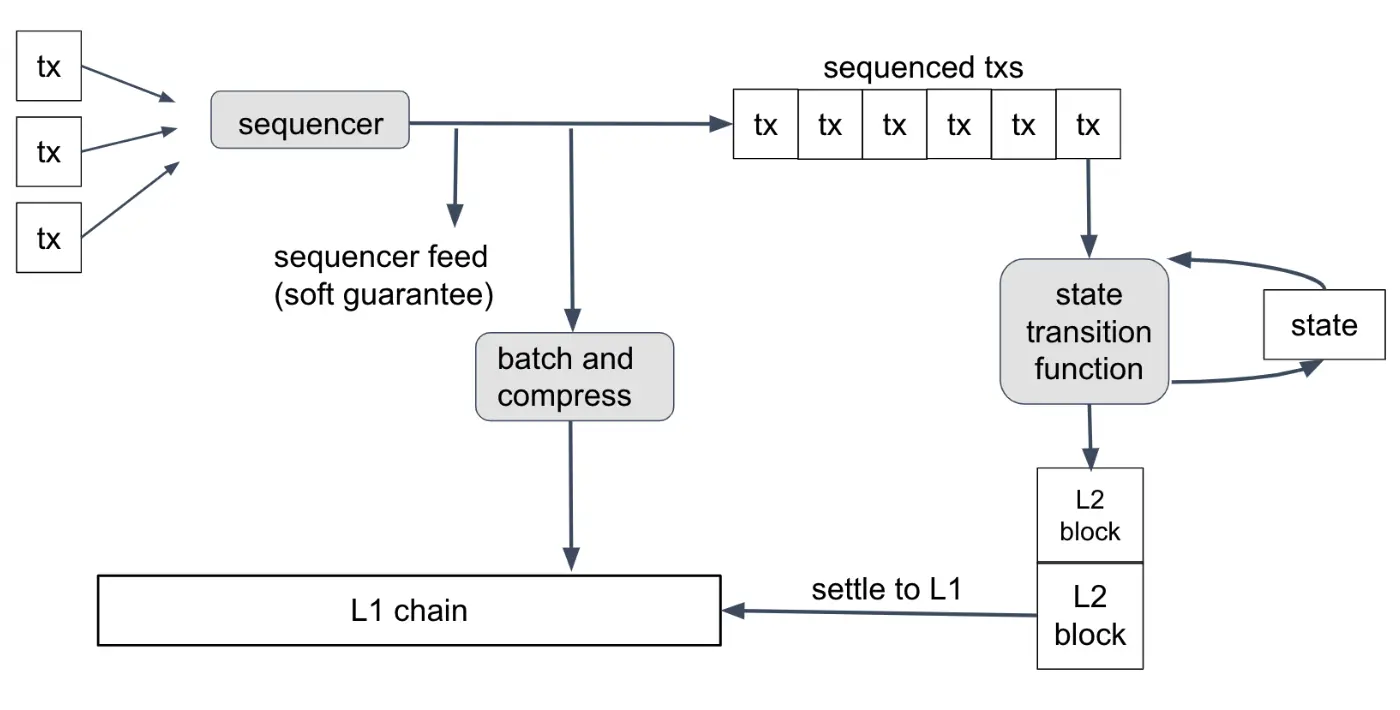

Một mô hình ngôn ngữ lớn (LLM) duy nhất được chia thành các phần khác nhau (hoặc các đoạn) và phân phối trên nhiều thiết bị di động. Cách tiếp cận này cho phép mỗi thiết bị chỉ xử lý một phần nhỏ của yêu cầu tính toán và lưu trữ tổng thể, làm cho việc chạy các mô hình phức tạp trở nên khả thi ngay cả trên các thiết bị có tài nguyên hạn chế. Dưới đây là cách hoạt động của nó:

Phân Đoạn Và Phân Phối Mô Hình

- Phân Đoạn Mô Hình:

- Mô hình ngôn ngữ lớn được chuyển đổi thành một đồ thị tính toán, trong đó mỗi hoạt động trong mạng lưới được biểu diễn dưới dạng một nút.

- Đồ thị này sau đó được chia thành các đồ thị con nhỏ hơn, mỗi đồ thị có khả năng hoạt động độc lập.

- Phân Bố Mô Hình Tối Ưu:

- Sử dụng tối ưu hóa tuyến tính, các đồ thị con (hoặc phân đoạn mô hình) này được gán cho các thiết bị di động khác nhau.

- Việc phân bổ này xem xét khả năng tính toán và bộ nhớ của từng thiết bị, đảm bảo sử dụng tài nguyên hiệu quả và giảm thiểu chi phí truyền dữ liệu giữa các thiết bị.

- Thực Thi Suy Diễn Hợp Tác:

- Mỗi thiết bị di động xử lý phần mô hình được gán của mình.

- Các thiết bị giao tiếp với nhau để trao đổi kết quả trung gian khi cần, đảm bảo nhiệm vụ suy diễn tổng thể được hoàn thành chính xác.

- Các chiến lược giao tiếp tối ưu được áp dụng để duy trì tính toàn vẹn của cấu trúc mô hình ban đầu và đảm bảo luồng dữ liệu hiệu quả.

Kịch Bản Ví Dụ

Hãy tưởng tượng một mô hình ngôn ngữ lớn như GPT-3 được chia thành nhiều phần. Một thiết bị di động có thể xử lý việc nhúng token ban đầu và một vài lớp đầu tiên của mô hình, trong khi một thiết bị khác xử lý các lớp giữa, và một thiết bị thứ ba hoàn thành các lớp cuối cùng và tạo ra đầu ra. Trong suốt quá trình này, các thiết bị chia sẻ kết quả trung gian để đảm bảo nhiệm vụ suy diễn mô hình đầy đủ được thực hiện một cách liền mạch.

Hiệu Suất và Kết Quả

Hiệu quả của LinguaLinked được chứng minh qua các thử nghiệm rộng rãi trên nhiều thiết bị Android khác nhau, cả cao cấp và phổ thông. Các phát hiện chính bao gồm:

- Tốc Độ Suy Diễn: So với nền tảng cơ bản, LinguaLinked tăng tốc hiệu suất suy diễn từ 1.11× đến 1.61× trong các cài đặt đơn luồng và từ 1.73× đến 2.65× với đa luồng.

- Cân Bằng Tải: Cân bằng tải thời gian thực của hệ thống càng tăng cường hiệu suất, với tổng tăng tốc từ 1.29× đến 1.32×.

- Khả Năng Mở Rộng: Các mô hình lớn hơn được hưởng lợi đáng kể từ việc phân bổ mô hình tối ưu của LinguaLinked, thể hiện khả năng mở rộng và hiệu quả của nó trong việc xử lý các tác vụ phức tạp.

Ứng Dụng Và Trường Hợp Sử Dụng

LinguaLinked đặc biệt phù hợp cho các tình huống mà quyền riêng tư và hiệu quả là điều quan trọng nhất. Các ứng dụng bao gồm:

- Tạo Văn Bản và Tóm Tắt: Tạo ra các văn bản mạch lạc và phù hợp với ngữ cảnh ngay trên các thiết bị di động.

- Phân Tích Tâm Trạng: Phân loại dữ liệu văn bản một cách hiệu quả mà không làm ảnh hưởng đến quyền riêng tư của người dùng.

- Dịch Thuật Thời Gian Thực: Cung cấp các bản dịch nhanh chóng và chính xác trực tiếp trên thiết bị.

Hướng Đi Tương Lai

LinguaLinked mở đường cho những tiến bộ hơn nữa trong lĩnh vực AI trên thiết bị di động:

- Hiệu Quả Năng Lượng: Các phiên bản tương lai sẽ tập trung vào việc tối ưu hóa tiêu thụ năng lượng để ngăn ngừa hao pin và quá nhiệt trong các tác vụ cường độ cao.

- Tăng Cường Quyền Riêng Tư: Các cải tiến tiếp tục trong xử lý phi tập trung sẽ đảm bảo quyền riêng tư dữ liệu thậm chí còn lớn hơn.

- Mô Hình Đa Phương Thức: Mở rộng LinguaLinked để hỗ trợ các mô hình đa phương thức cho các ứng dụng thực tế đa dạng.

Kết Luận

LinguaLinked đại diện cho một bước tiến lớn trong việc triển khai LLM trên các thiết bị di động. Bằng cách phân phối tải tính toán và tối ưu hóa việc sử dụng tài nguyên, nó làm cho AI tiên tiến trở nên khả dụng và hiệu quả trên nhiều thiết bị khác nhau. Sự đổi mới này không chỉ nâng cao hiệu suất mà còn đảm bảo quyền riêng tư dữ liệu, đặt nền tảng cho các ứng dụng AI di động cá nhân hóa và an toàn hơn.