L'intelligence artificielle est en train de remodeler notre monde numérique. Des assistants de codage efficaces aux puissants moteurs de génération de contenu, le potentiel de l'IA est évident. Cependant, alors que l'internet ouvert est progressivement remplacé par des "boîtes de prompt" individuelles, une question fondamentale se pose à nous : l'IA nous mènera-t-elle vers un internet plus ouvert, ou vers un labyrinthe contrôlé par quelques géants et rempli de nouveaux murs de paiement ?

Le contrôle – voilà le problème central. Heureusement, lorsqu'une force centralisatrice puissante émerge, une autre force décentralisatrice mûrit également. C'est là que la crypto entre en jeu.

La blockchain ne se limite pas à la monnaie numérique ; c'est un nouveau paradigme architectural pour la construction de services internet – un réseau neutre décentralisé et sans confiance qui peut être collectivement possédé par les utilisateurs. Elle nous fournit un ensemble d'outils puissants pour contrer la tendance de plus en plus centralisée des modèles d'IA, renégocier l'économie qui sous-tend les systèmes actuels, et finalement parvenir à un internet plus ouvert et plus robuste.

Cette idée n'est pas nouvelle, mais elle est souvent définie de manière vague. Pour rendre la conversation plus concrète, nous explorons 11 scénarios d'application qui sont déjà en cours d'exploration pratique. Ces scénarios sont ancrés dans les technologies en cours de développement aujourd'hui, démontrant comment la crypto peut relever les défis les plus urgents apportés par l'IA.

Première Partie : Identité—Redéfinir notre "Existence" dans le Monde Numérique

Dans un monde numérique où les robots et les humains sont de plus en plus indiscernables, "qui vous êtes" et "ce que vous pouvez prouver" deviennent cruciaux.

1. Contexte Persistant dans les Interactions IA

Problème : Les outils d'IA actuels souffrent d'"amnésie". Chaque fois que vous ouvrez une nouvelle session ChatGPT, vous devez lui redonner votre parcours professionnel, vos préférences de programmation et votre style de communication. Votre contexte est piégé dans des applications isolées et ne peut pas être transféré.

Solution Crypto : Stocker le contexte utilisateur (tel que les préférences, les bases de connaissances) en tant qu'actifs numériques persistants sur la blockchain. Les utilisateurs possèdent et contrôlent ces données et peuvent autoriser n'importe quelle application d'IA à les charger au début d'une session. Cela permet non seulement des expériences multiplateformes fluides, mais aussi aux utilisateurs de monétiser directement leur expertise.

2. Identité Universelle pour les Agents IA

Problème: Lorsque les agents IA commenceront à exécuter des tâches en notre nom (réservations, transactions, service client), comment les identifierons-nous, les paierons-nous et vérifierons-nous leurs capacités et leur réputation ? Si l'identité de chaque agent est liée à une seule plateforme, sa valeur sera considérablement diminuée.

Solution Crypto: Créer un "passeport universel" basé sur la blockchain pour chaque agent IA. Ce passeport intègre un portefeuille, un registre d'API, un historique des versions et un système de réputation. Toute interface (e-mail, Slack, un autre agent) pourra l'analyser et interagir avec lui de la même manière, construisant ainsi un écosystème d'agents sans permission et composable.

3. « Preuve de personnalité » à l'épreuve du temps

Problème : Les deepfakes, les armées de bots sur les réseaux sociaux, les faux comptes sur les applications de rencontre... La prolifération de l'IA érode notre confiance dans l'authenticité en ligne.

Solution Crypto : Les mécanismes décentralisés de « preuve de personnalité » (comme World ID) permettent aux utilisateurs de prouver qu'ils sont des humains uniques tout en protégeant leur vie privée. Cette preuve est auto-conservée par les utilisateurs, réutilisable sur différentes plateformes et compatible avec l'avenir. Elle peut clairement séparer les réseaux humains des réseaux de machines, jetant les bases d'expériences numériques plus authentiques et sécurisées.

Deuxième partie : Infrastructure décentralisée – Poser les jalons pour l'IA ouverte

L'intelligence de l'IA dépend de l'infrastructure physique et numérique qui la sous-tend. La décentralisation est essentielle pour garantir que ces infrastructures ne soient pas monopolisées par un petit nombre.

4. Réseaux d'Infrastructure Physique Décentralisés (DePIN) pour l'IA

Problème : Les progrès de l'IA sont limités par la puissance de calcul et les goulots d'étranglement énergétiques, ces ressources étant fermement contrôlées par quelques fournisseurs de cloud hyperscale.

Solution Crypto : Le DePIN agrège les ressources physiques sous-utilisées à l'échelle mondiale grâce à des mécanismes d'incitation—des PC de joueurs amateurs aux puces inactives dans les centres de données. Cela crée un marché de calcul distribué et sans permission qui abaisse considérablement la barrière à l'innovation en IA et offre une résistance à la censure.

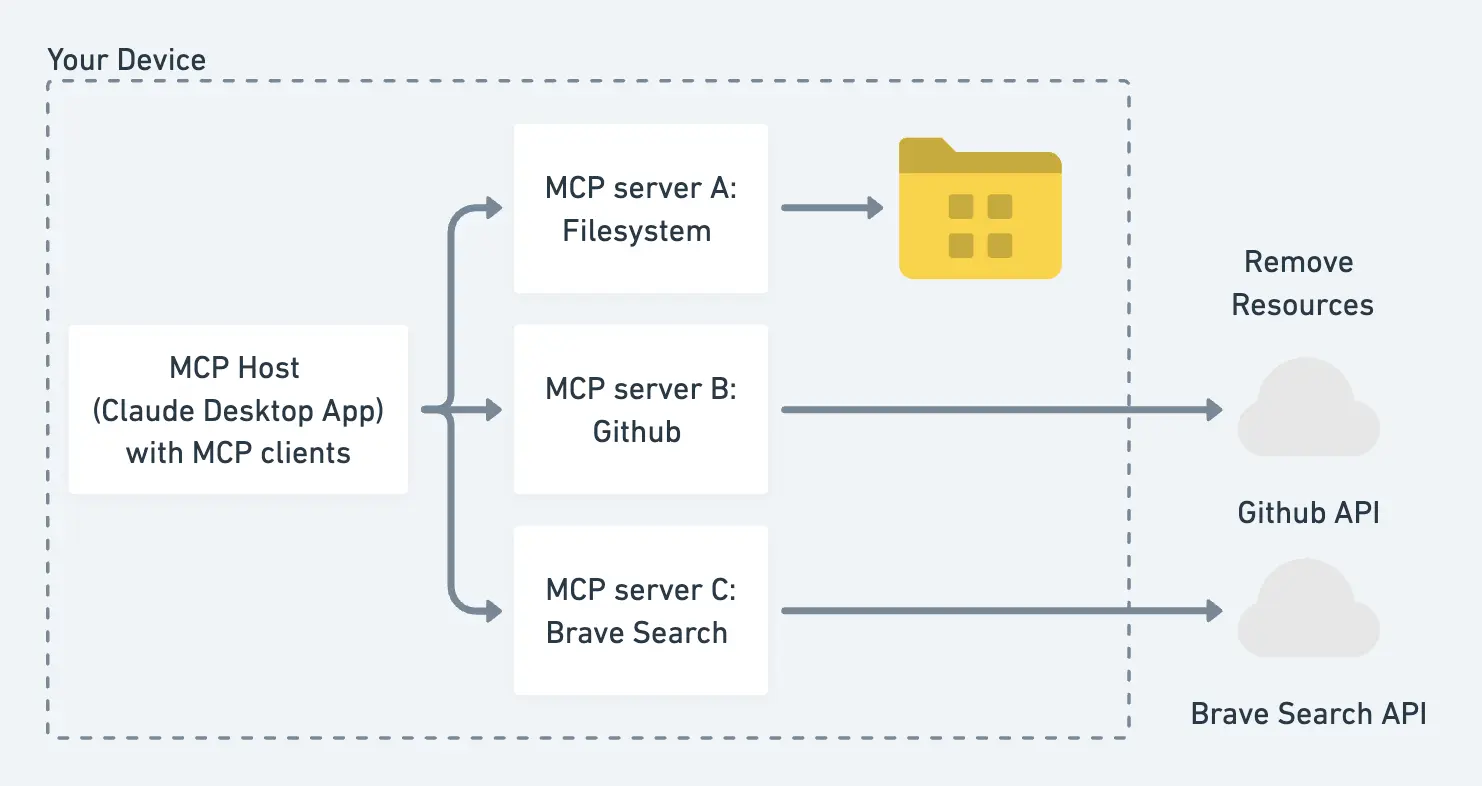

5. Infrastructure et garde-fous pour les interactions d'agents IA

Problème : Les tâches complexes nécessitent souvent la collaboration entre plusieurs agents IA spécialisés. Cependant, ils opèrent principalement dans des écosystèmes fermés, manquant de normes d'interaction et de marchés ouverts.

Solution Crypto : La blockchain peut fournir une "voie" ouverte et standardisée pour les interactions d'agents. De la découverte et la négociation au paiement, l'ensemble du processus peut être exécuté automatiquement sur la chaîne via des contrats intelligents, garantissant que le comportement de l'IA s'aligne sur l'intention de l'utilisateur sans intervention humaine.

6. Maintenir la synchronisation des applications codées par l'IA

Problème : L'IA permet à quiconque de créer rapidement des logiciels personnalisés ("Vibe coding"). Mais cela engendre un nouveau chaos : lorsque des milliers d'applications personnalisées en constante évolution doivent communiquer entre elles, comment assurer leur compatibilité ?

Solution Crypto : Créer une "couche de synchronisation" sur la blockchain. Il s'agit d'un protocole partagé et mis à jour dynamiquement auquel toutes les applications peuvent se connecter pour maintenir leur compatibilité mutuelle. Grâce à des incitations crypto-économiques, les développeurs et les utilisateurs sont encouragés à maintenir et à améliorer collectivement cette couche de synchronisation, formant ainsi un écosystème auto-développant.

Troisième partie : Nouveaux modèles économiques et d'incitation — Refaçonner la création et la distribution de valeur

L'IA bouleverse l'économie internet existante. La crypto offre une boîte à outils pour réaligner les mécanismes d'incitation, garantissant une juste rémunération pour tous les contributeurs de la chaîne de valeur.

7. Micropaiements de répartition des revenus

Problème : Les modèles d'IA créent de la valeur en apprenant d'énormes quantités de contenu internet, mais les créateurs de contenu originaux ne reçoivent rien. À terme, cela étouffera la vitalité créative de l'internet ouvert.

Solution Crypto : Établir un système d'attribution et de partage de revenus automatisé. Lorsqu'un comportement d'IA se produit (comme la génération d'un rapport ou la facilitation d'une transaction), les contrats intelligents peuvent automatiquement payer une minuscule somme (micropaiement ou nanopaiement) à toutes les sources d'information qu'il a référencées. Ceci est économiquement viable car cela s'appuie sur des technologies blockchain à faible coût comme les Layer 2.

8. Registre de la Propriété Intellectuelle (PI) et de la Provenance

Problème : À une époque où l'IA peut générer et remixer du contenu instantanément, les cadres traditionnels de la PI semblent insuffisants.

Solution Crypto : Utiliser la blockchain comme un registre public et immuable de la PI. Les créateurs peuvent établir clairement la propriété et définir des règles pour l'octroi de licences, le remixage et le partage des revenus via des contrats intelligents programmables. Cela transforme l'IA d'une menace pour les créateurs en une nouvelle opportunité de création et de distribution de valeur.

9. Faire payer les robots d'exploration web pour les données

Problème : Les robots d'exploration web des entreprises d'IA collectent librement les données des sites web, consommant la bande passante et les ressources de calcul des propriétaires de sites sans compensation. En réponse, les propriétaires de sites web commencent à bloquer ces robots d'exploration en masse.

Solution Crypto : Établir un système à double voie : les robots d'exploration d'IA paient des frais aux sites web via des négociations on-chain lors de la collecte de données. Pendant ce temps, les utilisateurs humains peuvent vérifier leur identité via une « preuve de personne » et continuer à accéder gratuitement au contenu. Cela permet à la fois de compenser les contributeurs de données et de protéger l'expérience utilisateur humaine.

10. Publicité Personnalisée et Non "Intrusive" Préservant la Confidentialité

Problème : La publicité actuelle est soit non pertinente, soit troublante en raison du suivi excessif des données des utilisateurs.

Solution Crypto : Les utilisateurs peuvent autoriser leurs agents IA à utiliser des technologies de confidentialité, telles que les preuves à divulgation nulle de connaissance, pour prouver certains attributs aux annonceurs sans révéler leur identité personnelle. Cela rend la publicité très pertinente et utile. En retour, les utilisateurs peuvent recevoir des micropaiements pour le partage de données ou l'interaction avec les publicités, transformant ainsi le modèle publicitaire "extractif" actuel en un modèle "participatif".

Quatrième partie : Posséder l'avenir de l'IA — Garantir que le contrôle reste aux utilisateurs

À mesure que notre relation avec l'IA devient de plus en plus personnelle et profonde, les questions de propriété et de contrôle deviennent cruciales.

11. Compagnons IA Détenus et Contrôlés par l'Humain

Problème : Dans un avenir proche, nous aurons des compagnons IA infiniment patients et hautement personnalisés (pour l'éducation, la santé, le soutien émotionnel). Mais qui contrôlera ces relations ? Si des entreprises détiennent le contrôle, elles peuvent censurer, manipuler, ou même supprimer votre compagnon IA.

Solution Crypto : Héberger les compagnons IA sur des réseaux décentralisés et résistants à la censure. Les utilisateurs peuvent véritablement posséder et contrôler leur IA via leurs propres portefeuilles (grâce à l'abstraction de compte et aux technologies clés, la barrière à l'utilisation a été considérablement réduite). Cela signifie que votre relation avec l'IA sera permanente et inaliénable.

Conclusion : Construire l'avenir que nous voulons

La convergence de l'IA et de la crypto n'est pas seulement la combinaison de deux technologies en vogue. Elle représente un choix fondamental quant à la forme future d'internet : Allons-nous vers un système fermé contrôlé par quelques entreprises, ou vers un écosystème ouvert collectivement construit et possédé par tous ses participants ?

Ces 11 scénarios d'application ne sont pas de lointains fantasmes ; ce sont des directions activement explorées par la communauté mondiale des développeurs, y compris de nombreux bâtisseurs de Cuckoo Network. La route à parcourir est pleine de défis, mais les outils sont déjà entre nos mains. Maintenant, il est temps de commencer à construire.